网络爬虫

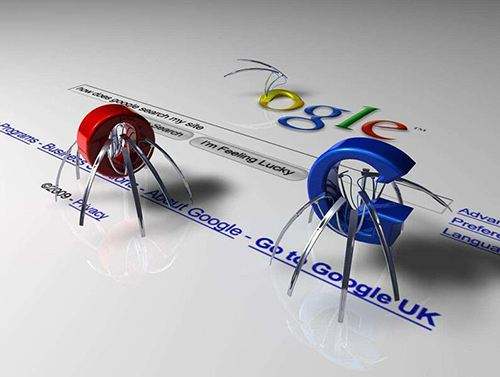

责编:gltian |2020-08-13 16:06:37网络爬虫(又称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

随着网络的迅速发展,万维网成为大量的信息的载体,如何有效地提取并利用这些信息成为一个巨大的挑战。因为爬虫技术造成的大量IP访问网站侵占带宽资源、以及用户隐私和知识产权等危害,很多互联网企业都会花大力气进行“反爬虫”。

相比爬虫技术本身,反爬虫其实更加复杂,发展历程也更加有趣。就拿电商网站来说,很多电商网站是愿意被比价网站或者其他购物信息网站爬取信息的,因为这样能够给他们的商品带来更多流量。但他们不愿意被其他电商网站获取价格信息和商品描述,因为担心其他电商网站恶意比价或进行抄袭。同时他们又经常去爬其他电商网站的数据,希望能够看到别人的价格。

在90年代开始有搜索引擎网站利用爬虫技术抓取网站时,一些搜索引擎从业者和网站站长通过邮件讨论定下了一项“君子协议”—— robots.txt。即网站有权规定网站中哪些内容可以被爬虫抓取,哪些内容不可以被爬虫抓取。这样既可以保护隐私和敏感信息,又可以被搜索引擎收录、增加流量。

爬虫技术刚刚诞生时我们的技术还不是很完善,大多数从业者都会默守“君子协定”,毕竟那时候信息和数据都没什么油水可捞。但很快互联网上开始充斥着商品信息、机票价格、个人隐私等等,在利益的诱惑下,自然有些人会开始违反爬虫协议了。可以说爬虫技术和反爬虫技术之间争斗了十几年,可真正的“战争”,却从现在才刚刚开始。

.jpg)

.png)