GeekPwn大赛百万悬赏AI黑客 CAAD攻防赛聚焦大热对抗样本

责编:gltian |2018-04-20 13:25:05在人类的不懈努力下,AI 越来越像人,连犯的错误都像。

过去几年中,被喻为“新电力”的人工智能已经走出科幻小说,成为新一代”网红“。

这里称其“网红”,并不是想贬低那些钻研数十载的 AI 科研者。毕竟,没有他们在人工智能这一计算机科学分支领域的不懈耕耘,就不可能有后来成百上千个的域名以 .ai 结尾的初创公司拿到巨额风险投资。

机器能思考吗?

回顾人工智能八十年来的发展历程,始终没有逃离艾伦•图灵 1950 年的那个问题:机器能思考吗?1955 年,人工智能(artificial intelligence)一词横空出世。次年,十名科学家天真地预想用两个月的时间搞清楚这个问题。

即便棋艺卓越的 AlphaGo 也不敢说自己会思考。抱歉,AlphaGo 甚至还不会说话。面对这个依旧无法回答的未解之谜,你或许可以引用另一个计算机科学家戴客斯特拉(Dijkstra)的话反问:“潜艇会游泳吗?”

人工智能的奇点与盲点

谈起人工智能,一千个人及媒体眼中就有一千种定义。毫无疑问的是,深度学习领衔的“机器学习帮”让机器变得更聪明了。

目前,从图像识别、语音识别、自然语言理解到机器翻译等,深度学习一度成为人工智能领域研究的宠儿。自 2012 年,Krizhevsky 等人利用卷积神经网络(CNN)大幅提升了计算机视觉的识别能力,一个新时代的开始。

Nick Bourdakos 在一篇博客里用好莱坞巨星卡戴珊的照片进行了简易说明 CNN。作为图像分类领域最先进的方法之一,CNN 通过将每一层神经网络对应的特征累积起来进行对象识别。整个过程中,所有特征的空间关系就会丢失。

当我们把 CNN 看做是“如果有两只眼睛、一个鼻子和一个嘴巴,它就是一张脸”的程序,就会出现以下问题:

这当然不是一张脸了,但是 CNN 就会说“这是一张脸”。有趣的地方就在于如果我们知道机器只会把“两只眼睛、一个鼻子和一张嘴”看成一张脸,是不是就可以欺骗机器呢?

早在 2013 年,Christian Szegedy 等人发现在数据集中故意添加细微干扰形成的输入样本,能够让判别模型输出一个错误结果。他们称之为“对抗样本”(Adversarial examples)。

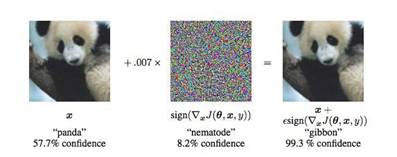

通过制造对抗样本,研究者让机器从图中是熊猫的可能性大约 57.7%,变为相信图中是长臂猿的可能性高达 99.3%。这不仅仅是机器的一个错觉,但是一个非常“确定”的错觉。

2015 年,谷歌大脑人工智能科学家 Ian Goodfellow 等人发现模型的线性特征导致其对对抗样本产生了脆弱性。

尽管不同模型使用的结构不同,但是因为学习了相似的函数,造成了一种模型的对抗样本在另一个模型上也会被错误分类。

2016 年,Ian Goodfellow等人发现将图像打印出来之后对抗样本依旧具有“对抗性”,能够让分类器将小鸟照片识别成飞机。这让“对抗样本”不仅仅是纸上谈兵,在现实中也会造成影响。

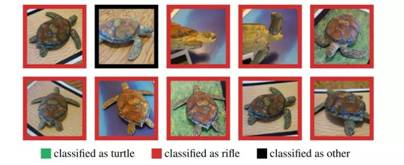

2017 年,麻省理工学院的Anish Athalye 等人让 3D 打印出的真实物体也能欺骗深度网络分类器。一个乌龟玩具被谷歌识别系统看成了来复枪。

加州大学伯克利分校的李博等研究者利用小贴纸在交通标识牌上进行一些微小的“装饰”,就让图像识别系统 100% 产生错误判断。试想如果这是一辆行驶中的自动驾驶汽车, 那么别有用心的人随时都能制造一起车祸。

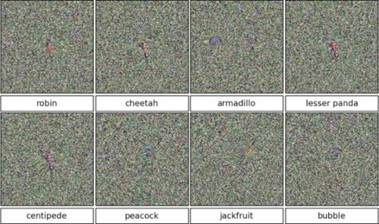

2018 年,谷歌大脑研究者生成了能够同时愚弄人类和机器视觉对抗性图像。潘多拉的魔盒已经打开,更有激进的日本研究者仅仅通过修改 1、3、5 个像素就达到欺骗 DNN 模型的成果。

拿什么防御“对抗样本”?

机器学习模型无疑有着广泛的攻击面,宾夕法尼亚州立大学 Nicolas Papernot 博士说:“无论是用何种机器学习模型,也不论需要解决哪些任务,这类通用攻击都会经常发生。”

2017 年加州大学伯克利分校博士生 Nicholas Carlini 在一篇论文中,“攻破”了 10 个不同的针对“对抗攻击”的防御计划。此前 Ian Goodfellow归纳可以通过对抗训练(adversarial training)和差分隐私(differential privacy)进行防御,而迄今为止,依然没有一种完整的解决方法能够有效阻止“对抗样本”攻击。

2018 年,MIT 和 UC Berkeley 的研究者指出当下大部分对抗样本防御方法依赖于“混淆梯度”(obfuscated gradients)现象,即通过提供错度的梯度给攻击者而让基于梯度的对抗样本失效,从而达到防御。来自 MIT 的Athalye 宣称 ICLR(一场顶级机器学习大会)接收的论文中,八篇关于防御的论文(实际有十一篇)其中有七篇已经被他们攻破,其中不乏来自谷歌、亚马逊及斯坦福等机构。

卡内基梅隆大学教授 Zachary Lipton 表示,对抗样本针对所有现有的防御措施都可以避开的情况,是合理的。加州大学伯克利分校的博士后李博则认为具备更接近人类视角的机器或许会减少幻觉影响,他们正在与神经科学家、生物学家展开合作。

深度学习的先驱研究人员之一、现就职于谷歌的 Geoff Hinton 在 2017 年提出“胶囊网络”(Capsule Networks)的概念。神经网络需要依赖海量数据进行学习,很长时间才能认识到从不同角度观察的对象是同一个物体。相比之下“胶囊网络”是一种人造神经元组成的层,跟踪物体的各个部分之间的关系让识别更快更准确。

现有的研究结果已经证明“胶囊网络”对对抗样本具有“抗性”,比 CNN 的错误数量减少了 45%。然而“胶囊网络”就是治疗“对抗样本”的良药吗?

GeekPwn 黑客大赛:百万奖金池,鼓励AI 黑客火力全开

为了推进 AI 安全领域的研究,通过对抗样本推动AI的不断成长,率先关注 AI 安全的世界黑客大赛 GeekPwn(极棒)联合谷歌大脑、加州大学伯克利分校 EECS 顶级专家创办了首届 CAAD 对抗样本攻防赛(Competition on Adversarial Attacks and Defenses),官网地址 caad.geekpwn.org。

2018 年,CAAD 将聚焦机器学习图像识别领域的安全攻防对抗研究,特设非定向对抗攻击、定向对抗攻击、对抗攻击的防御三个挑战类别。官方报名通道及详细规则将于五月开启公布,获胜选演示及颁奖会在八月 GeekPwn 拉斯维加斯站举行。本次大赛设立了15万美元的总奖金池,鼓励广大 AI 研究者加入到安全对抗的领域中,做未来的安全守护者。

自 2016 年以来,GeekPwn 黑客大赛注意到人工智能存在的潜在安全隐患,陆续推出了 AI PWN、PWN AI、“AI 仿声验声攻防赛”等区别于传统的黑客攻防挑战的前沿比赛项目。2018年GeekPwn大赛非命题的项目报名也已同步开启,总奖金池500万人民币,选手可以自由选择挑战对象,任意 AI 产品、服务甚至是 AI 框架;亦或使用 AI 技术作为工具进行黑客破解或者利用。详细的参赛指引可查阅官网www.geekpwn.org。

在历届极棒比赛中,“AI PWN”选手曾利用 3D 打印机和深度学习算法写出足以骗过专业笔迹鉴定师的仿真字迹;“PWN AI”选手通过 CNN 算法两分钟破解谷歌 reCAPTCHA 图形验证码;多组参加了“AI 仿声验声攻防赛”的团队仅仅通过 20 分钟的音频就能生成足以突破AI声纹锁的语音片段……

为更深层次挖掘AI服务安全的未来价值,GeekPwn也在策划全新的“数据追踪挑战赛”。能够多维度将不同来源的数据关联并得出准确结果是一种先进的技术。例如,通过爆破地点的数据、匿名举报电话以及社交媒体等信息结合追踪炸弹制造者;对历史记录、海量数据充分分析之后发现金融骗局;通过分析大量代码,找到编程者等等。数据追踪挑战赛挑战要求选手通过主办方提供的数据集运用 AI 等工具进行分析研究,并最终完成指定目标。

当越来越多的研究者关注 AI 安全领域并投入精力研究,未来 AI 发展才能更加稳健、更好地提供服务、创造价值。

关注GeekPwn获取更多比赛信息